Das diesjährige AWS-Jahresabschluss-Event re:Invent 2018 ist mit dem notwendigen Brimborium über die Bühne gegangen. Dieser und folgende Beiträge fassen die wichtigsten Neuerungen und Ankündigungen zusammen, darunter auch 13 neue Machine-Learning-Dienste und KI-Funktionen.

AWS hat 13 neue Dienste und Funktionalitäten über alle Schichten des AWS Machine-Learning (ML)-Angebots hinweg angekündigt und legt damit ML noch stärker in die Hände der Entwickler. Dazu zählen neben neuer Infrastruktur, ein eigener Machine-Learning-Chip und verbesserte Frameworks für schnelleres Training und kostengünstigere Inferenz.

Neuer P3-Instanztyp für ML

Unter anderem steht mit den ab sofort verfügbaren P3dn.24x-Instanzen ein neuer Amazon EC2 GPU-Instanz-Typ zur Verfügung, der zu den leistungsfähigsten unter den in der Cloud verfügbaren Instanzen gehört. P3dn.24x-Instanzen bieten 96 Intel “Skylake” vCPUs, 8 nVidia V100 GPUs, 32GB GPU-Speicher, schnellen NVMe-Massenspeicher und 100 Gbps-Netzwerkadapter, auf deren Basis Entwickler Modelle mit mehr Daten in kürzerer Zeit trainieren können.

AWS-optimiertes TensorFlow Framework

Ferner verbessert das ebenfalls ab sofort verfügbare AWS-optimierte TensorFlow Framework die Art und Weise, wie TensorFlow Trainingsaufgaben auf die GPUs verteilt und erlaubt so schnellere ML-Trainings. Das TensorFlow Framework erreicht damit eine 90-prozentige Effizienz beim Training auf 256 GPUs gegenüber dem früheren Wert von 65 Prozent. Mit diesem Framework und den neuen P3dn-Instanzen lässt sich das populäre ResNet-50-Modell in nur 14 Minuten trainieren. Dieser neue Rekord schlägt die bisherige Bestzeit um 50 Prozent.

GPU-Accelearation

Ebenfalls ab sofort verfügbar ist Amazon Elastic Inference. Amazon Elastic Inference ermöglicht es Entwicklern, die Kosten für Inferenz drastisch zu senken und Einsparungen bis zu 75 Prozent im Vergleich zu den Kosten für die Verwendung einer dedizierten GPU-Instanz zu erzielen.

Eigener Chip

Für 2019 dann hat AWS auf der Re:invent mit AWS Inferentia einen leistungsstarken, selbstentwickelten Chip für ML-Inferenzen angekündigt, der sich vor allem für größere Workloads, die ganze GPUs oder geringere Latenz benötigen, eignet. Er liefert Hunderte von Teraflops pro Chip und Tausende von Teraflops pro EC2-Instanz und unterstützt mehrere Frameworks wie TensorFlow, Apache MXNet und PyTorch sowie verschiedene Datentypen wie INT-8, mixed precision FP-16 und bfloat16.

Neue Amazon SageMaker Funktionalitäten und Algorithmen

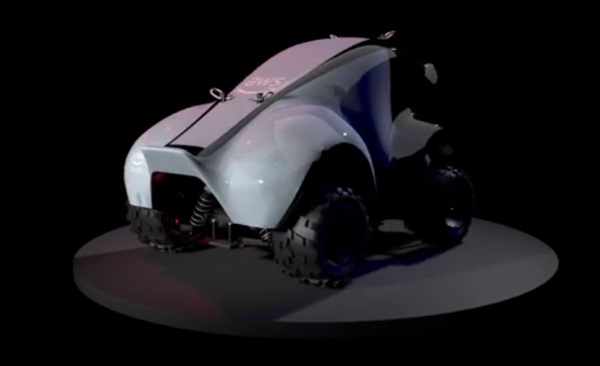

Darüber hinaus hat AWS auf der re:invent zahlreiche neue Funktionalitäten für seinen verwalteten ML-Dienst Amazon SageMaker vorgestellt, die ein vereinfachtes Erstellen, Trainieren und Bereitstellen von ML-Modellen erlauben, darunter mit AWS DeepRacer einen durch Reinforcement Learning betriebenes autonomes Rennwagen im Maßstab 1:18 für Entwickler.

AWS DeepRacer kann übrigens auf Amazon.com ab sofort vorbestellt werden. Mit Deep Racer können Entwickler in nur wenigen Zeilen Code mit einem vollständig autonomen Rennauto im Maßstab 1:18 Reinforcement Learning (RL) testen. Das Auto fährt mit Hilfe von RL-Modellen, die mit Amazon SageMaker trainiert wurden. In der DeepRacer League, der ersten weltweiten autonomen Rennliga, können Entwickler ihre Fähigkeiten unter Beweis stellen und mit ihren Autos und Modellen gegen andere antreten.

Auch ab sofort verfügbar ist Amazon SageMaker RL, der erste Cloud Service für Reinforcement Learning (RL), bei dem Modelle ohne die Notwendigkeit großer Datenmengen trainiert werden können, sofern die Nutzenfunktion bekannt, aber der Pfad für ihre Realisierung schwer zu bestimmen ist. Der Dienst ermöglicht es jedem Entwickler, Machine Learning (ML) Anwendungen mithilfe von Reinforcement Learning Algorithmen zu bauen, zu trainieren und zu betreiben. Dabei werden verschiedene Frameworks wie Intel Coach und Ray RL unterstützt, sowie Simulations-Umgebungen wie SimuLink, MatLab und der neue Robotik-Service AWS RoboMaker.

Das ab sofort verfügbare Amazon SageMaker Ground Truth vereinfacht die Zuordnung von Merkmalen zu Daten (auch „Labeling“ genannt) für die Aufbereitung von Trainingsdaten für maschinelles Lernen. Dabei können Entwickler auf einfache Weise ihre Daten mit Hilfe von menschlichen Annotatoren über Mechanical Turk, Drittanbieter oder eigene Mitarbeiter kennzeichnen.

Amazon SageMaker Ground Truth lernt in Echtzeit aus diesen Annotationen, kann einen Großteil des verbleibenden Datensatzes automatisch kennzeichnen und reduziert damit die Notwendigkeit einer menschlichen Überprüfung. Es erstellt hochpräzise Trainingsdatensätze, spart Zeit und Komplexität und reduziert die Kosten um bis zu 70 Prozent im Vergleich zu rein menschlicher Annotation.

Darüber hinaus bietet der ab sofort verfügbare AWS Marketplace for Machine Learning eine täglich wachsende Anzahl von derzeit über 150 Algorithmen und Modelle, die direkt auf Amazon SageMaker bereitgestellt und von Entwicklern verwendet werden können.

Der neue Compiler für Deep-Learning-Modelle Amazon SageMaker Neo ist ebenfalls ab sofort generell verfügbar und ermöglicht es Kunden, Modelle einmalig zu trainieren und diese überall mit bis zu doppelter Leistungssteigerung auszuführen. Er erstellt Modelle für spezifische Hardwareplattformen und optimiert automatisch deren Leistung. So können sie mit bis zu doppelter Leistung laufen, ohne an Genauigkeit einzubüßen. Dadurch müssen Entwickler ihre Trainingsmodelle nicht mehr für jede einzelne Hardwareplattform manuell optimieren (Zeit- und Kostenersparnis). Amazon SageMaker Neo unterstützt Plattformen wie NVIDIA, Intel, Xilinx, Cadence und Arm sowie beliebte Frameworks wie TensorFlow, Apache MXNet, und PyTorch. AWS wird Neo als Open Source Projekt veröffentlichen.

Neue KI Dienste

Weitere neue auf der re:invent vorgestellte KI-Dienste bringen Intelligenz in alle Apps, ohne dass dazu Erfahrungen in Machine Learning erforderlich sind.

Amazon Textract nutzt maschinelles Lernen, um praktisch jedes gescannte Dokument sofort zu lesen und Text und Daten präzise zu extrahieren. Hierfür sind weder manuelle Überprüfung oder benutzerdefinierter Code erforderlich. Amazon Textract ermöglicht es Entwicklern, Dokumenten-Workflows schnell zu automatisieren und verarbeitet Millionen von Dokumentenseiten innerhalb weniger Stunden. Eine Preview ist ab sofort verfügbar.

Auch Amazon Personalize ist ab sofort als Preview verfügbar. Hierbei handelt es sich um einen Empfehlungs- und Personalisierungsdienst in Echtzeit, der über 20 Jahre Personalisierungs-Erfahrung bei Amazon.com basiert. Der vollständig verwaltete Service erstellt für praktisch jeden Anwendungsfall nutzerdefinierte, eigene Personalisierungs- und Empfehlungsmodelle bereit und trainiert sie. Amazon Personalize kann Empfehlungen geben, Suchergebnisse personalisieren und Kunden für personalisiertes und direktes Marketing segmentieren.

Amazon Comprehend Medical ist ab sofort generell verfügbar und verwendet Natural Language Processing (NLP) für die Verarbeitung von medizinischen Texten. Hierbei handelt es sich um einen hochpräzisen NLP-Service, der mit Hilfe maschinellen Lernens Krankheitszustände, Medikation und Behandlungsergebnisse aus Patientennotizen, klinischen Studien und anderen elektronischen Gesundheitsakten extrahiert. Hierfür sind weder ML-Fachkenntnisse notwendig noch müssen komplizierte Regeln geschrieben oder Modelle trainiert werden. Amazon Comprehend Medical wird ständig verbessert und Kunden zahlen nur für das, was Sie nutzen – ohne Mindestgebühren oder Vorabverpflichtungen.

Schließlich ist auch Amazon Forecast ab sofort als Preview verfügbar und erstellt präzise Zeitreihenprognosen. Anhand historischer Daten und zugehöriger kausaler Daten wird Amazon Forecast automatisch benutzerdefinierte, private ML-Prognosemodelle trainieren, anpassen und bereitstellen. Kunden erhalten so mehr Sicherheit darüber, dass sie ihren Kunden die richtige Benutzererfahrung bieten und gleichzeitig ihre Ausgaben optimieren können.